Stellen Sie sich vor: Der Job ist weg, die Bewerbung erfolglos. Letzte Möglichkeit, die Wohnung nicht zu verlieren ein Kredit, doch auch der wird abgelehnt. Nur die wenigsten wissen, wer – oder besser gesagt was – hinter all diesen Entscheidungen steckt: Algorithmische Entscheidungssysteme. Sie sortieren Bewerbungen, schätzen die Kreditwürdigkeit oder den Pflegebedarf ein. Doch wie transparent und fair ist der Algorithmus dabei?

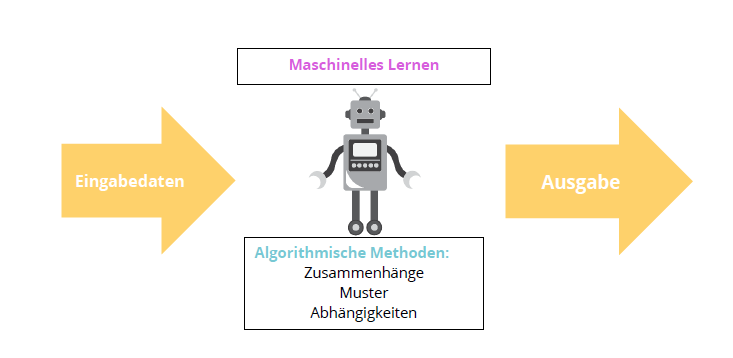

„Es ist wichtig zu unterscheiden, um welche Art von Algorithmus es sich handelt“, betont Thomas Schmid, Leiter der Arbeitsgruppe Maschinelles Lernen an der Universität Leipzig. „Der klassische Algorithmus ist nur eine Handlungsanweisung, also tue dies, tue das, wenn x dann y. Sie sind relativ unproblematisch, da man sie als Informatiker gut überprüfen und verändern kann“, führt Schmid weiter aus. Bei einem Algorithmischen Entscheidungssystem müsse zwischen zwei verschiedene Arten von Algorithmen unterschieden werden. Regelbasiert und datenbasiert.

Regelbasierte vs datenbasierte Algorithmen

„Der regelbasierte Algorithmus ist sehr nahe an der ursprünglichen Idee der Handlungsanweisung, da nach wie vor Regeln und Kriterien vom Programmierer festgelegt werden“, erklärt der Informatiker. Dieser sei vergleichsweise gut zu interpretieren, überprüfen und warten. So könne er jederzeit angepasst werden, anders als bei datenbasierten Algorithmen. Das Entscheidungssystem erhält keinerlei Vorgaben oder Kriterien, sondern lediglich Daten sowie die gewünschte Ausgabe. Sie passen sich den Informationen an und lernen daraus. Deshalb werden sie auch lernende Algorithmen genannt.

„Ähnlich wie bei einem kleinen Kind lernt das System nicht nur Dinge, die es soll, oder die wir vorgesehen haben“, kommentiert Schmid die lernenden Systeme. So imitieren sie, was wir ihnen vorleben – auch entsprechende Vorurteile im eigenen Entscheidungsprozess. Zudem seien die Entscheidungen des datenbasierten Algorithmus nur sehr schwer nachvollziehbar.

„Das Problem ist die Anzahl an personenbezogenen Daten, die in den letzten Jahren unheimlich gewachsen ist“

Carsten Orwat

Carsten Orwat ist wissenschaftlicher Mitarbeiter beim Institut für Technikfolgenabschätzung und Systemanalyse an der Universität Karlsruhe. Die gesammelten Daten seien sogar so wertvoll, dass Unternehmen diese untereinander handeln.

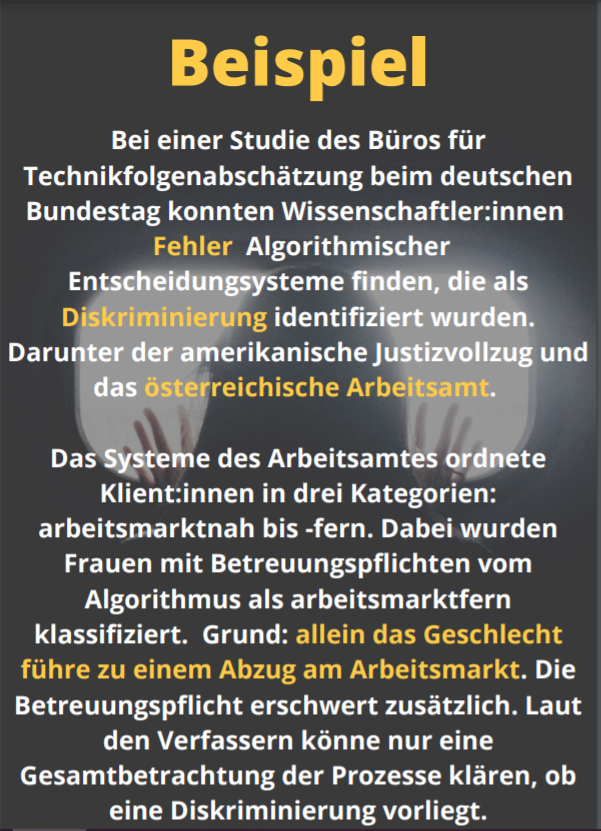

Das Entscheidungssystem verarbeitet diese Informationen und zieht Schlussfolgerungen, indem es Zusammenhänge und Muster erkennt. Dabei werden jedoch auch triviale Fakten zur Einflussgröße. Zumal geschützte Merkmale wie Alter, Geschlecht, sexuelle Orientierung, Herkunft und Religion gar nicht in den Entscheidungsprozess einfließen dürfen.

„Selbst wenn die Daten vorab bereinigt wurden, erkennt das System durch Drittvariablen die verborgene Information“, erklärt der Wissenschaftler. Drittvariablen, auch Proxy genannt, sind Hinweise, durch die auf die eigentliche Information geschlossen werden kann. Kauft eine Person im Internet Röcke, so ist es sehr wahrscheinlich, dass es sich um eine Frau handelt.

So sieht ein Programmiercode für maschinelle Lernsysteme aus

# Show dataset

show_dataset (X, Y)

# Split dataset

X_train, X_test, Y_train, Y_test = train_test_split(X, Y, test_size=0.30)

# Create logistic regressor

lr = LogisticRegression()

lr.fit(X_train, Y_train)

print('Logistic regression score: %.3f' % lr.score(X_test, Y_test))

# Compute CV score

lr_scores = cross_val_score( lr, X, Y, scoring='accuracy', cv=10)

print('Logistic regression CV average score: &.3f' % lr_scores.mean())

# Show classification areas

show_classification_areas(X, Y, lr)„Besorgniserregend sind Algorithmen immer dann, wenn die Teilhabechance von ihnen abhängt und sie damit einen massiven Einfluss auf unser Leben haben“, betont Lajla Fetic, Leiterin des Projektes „Ethik und Algorithmen“ der Bertelsmann Stiftung. Einfache Recommender-Systeme wie Serien- oder Musikvorschläge von Spotify und Netflix seien laut der Wissenschaftlerin weniger problematisch. Hingegen müssen Bürger:innen bei kritischen Bereichen wie Bewerbungen, Krediten und Leistungen vom Staat über den Einsatz von Entscheidungssystemen aufgeklärt werden.

„Betroffene müssen wissen, wo sie die algorithmischen Entscheidungen hinterfragen können“

Lajla Fetic

Betreiber, die das System von Entwicklern kaufen, verstehen jedoch oft nicht, wie das System funktioniert und können so das Ergebnis nicht erklären. Dabei werden sie im Falle einer Diskriminierung zur Verantwortung gezogen. Zwar unterliegen Software-Hersteller einer Art Produkthaftung, schlussendlich sind aber die Betreiber für die Verwaltung der Algorithmischen Entscheidungssysteme zuständig.

Vor Gericht werden viele Fälle jedoch gar nicht erst behandelt, da die Diskriminierung durch eine Maschine nur kaum bis sehr schwer feststellbar ist. Betroffene registrieren diese oft gar nicht. So werden bei der Arbeitssuche eher männlich besetzte Jobs zum größten Teil nur Männern angezeigt. Frauen werden diese erst gar nicht vorgeschlagen. Dadurch ist ihnen die Diskriminierung nicht bewusst. „Es liegt auf der Hand, dass der Algorithmus diskriminieren kann. Doch auch dort, wo der Computer Entscheidungen trifft, gilt das allgemeine Gleichbehandlungsgesetz“, erklärt Niklas Hofmann von der Antidiskriminierungsstelle des Bundes.

Dieses Gesetz legt Bereiche fest, in denen es zu keiner Andersbehandlung kommen darf. Das sind Arbeit, Zugang zu Gütern und Dienstleistungen, Versicherungen, Kredite und Wohnungsmarkt. „Betroffene sind vor allem die Gruppen, die es auch schon vorher waren. Es muss also eine Möglichkeit geben, sowohl präventiv als auch aktiv dieses Recht durchzusetzen“, betont Hofmann eindringlich. Erforderlich wäre dazu eine Dokumentations- und Kennzeichnungspflicht.

In diesem Podcast geht Niklas Hofmann im Detail auf die rechtliche Lage von Algorithmischen Entscheidungssystemen ein.

Die Europäische Kommission hat im April dieses Jahres einen Leitfaden für die Regulierung der Verwendung von Künstlicher Intelligenz herausgegeben. Dabei werden die Anwendungsbereiche nach Risikoeinstufungen eingeteilt und ein rechtlicher Rahmen vorgegeben. Verboten werden Anwendungen, die über ein hohes Schadenspotenzial verfügen. So auch autonome Waffensysteme, besser bekannt als Killerdronen. Derzeit werde auch in Deutschland über die Implementierung dieser Vorschläge diskutiert.

Ein weiteres Problem ist jedoch der individuelle Rechtsanspruch. Öffentliche Stellen können demnach lediglich beraten, den Rechtsweg müssen Betroffene allein bestreiten. „Im Antidiskriminierungsrecht ist das Verbandssammelklagerecht schon lange Thema vieler Diskussionen. Der individuelle Rechtsanspruch kommt schnell an seine Grenzen. Umso wichtiger wäre es, dass Stellen die Interessen vertreten können“, berichtet Hofmann.

Algorithmische Entscheidungssysteme diskriminieren systematisch, nicht individuell. So benachteiligen sie eine ganze Gruppe von Menschen. Nur sehr selten kommt eine Klage zu Stande, daher bleiben viele Fälle ungeklärt. Gerichte verfügen zudem nicht über die nötigen Kapazitäten, um die komplexen Systeme nachzuvollziehen. „In solchen Fällen muss es für Verbände möglich sein, die Interessen großer Gruppen auch potenziell Geschädigter zu vertreten“, betont der Hofmann.

Team Mensch-Maschine sorgt für die besten Ergebnisse

Trotz allem haben Algorithmische Entscheidungssysteme durchaus ihre Daseinsberechtigung. Bestimmte Prozesse wie Bild- oder Spracherkennung können nicht durch ursprüngliche Algorithmen programmiert werden. Für viele sind diese jedoch bereits fester Bestandteil im Alltag. So müssen Wege gefunden werden, die Systeme transparenter zu gestalten. So können Chancen genutzt und Risiken minimiert werden.

Dieser Aufgabe widmeten sich bereits mehrere Projekte. So auch die neun sogenannten Algo.Rules. Dabei handelt es sich um einen Katalog bestehend aus Regeln, die beachtet werden müssen, um eine gesellschaftlich förderliche Gestaltung und Überprüfung von Entscheidungssystemen zu gewährleisten. Sie wurden von Lajla Fetic zusammen mit einem Team entwickelt. Die Algo.Rules sollen eine Grundlage für ethische Erwägungen und die Durchsetzung rechtlicher Rahmenbedingungen bieten, die bereits bei der Entwicklung mitbedacht und implementiert werden können.

AlgorithmWatch richtet sich hingegen mit dem Projekt Autocheck an Mitarbeiter:innen von Antidiskriminierungsstellen. Mithilfe von Handlungsanleitungen und Workshops sollen sie in der Lage sein, Risiken besser einzuschätzen und zu erkennen. Bei konkreten Diskriminierungsfällen sollen so Betroffene besser unterstützt werden.

„Es sind nicht algorithmische Systeme, die diskriminieren. Das können nur Menschen, und das passierte auch schon vor dem Algorithmeneinsatz“

Lajla Fetic

Das System reproduziere lediglich, was wir ihm vorleben. Die Wissenschaftlerin sieht den Algorithmus sogar als Chance, an den eigenen Vorurteilen zu arbeiten. „Algorithmen halten uns einen Spiegel vor, wie irrational und ungern wir manchmal Entscheidungen treffen“, führt sie weiter aus.

Für die Automatisierung einer Entscheidung sei es wichtig, bereits vorher zu überlegen, welche Kriterien eine Rolle spielen dürfen und wie diese mit einem Code umgesetzt werden können. Dadurch entstehe sogar mehr Transparenz, da die Maschine nicht intuitiv vorgehen könne. „Wenn Mensch und Maschine zusammenarbeiten, entstehen die besten Ergebnisse. Digitalisierung ist lediglich ein Werkzeug. Es liegt an uns, das Potential zu nutzen“, bilanziert Lajla Fetic.

Externe Quellen:

- https://www.antidiskriminierungsstelle.de/SharedDocs/downloads/DE/publikationen/Expertisen/studie_diskriminierungsrisiken_durch_verwendung_von_algorithmen.pdf;jsessionid=F7789254B2597E21ADC20C632EAAE61B.intranet211?__blob=publicationFile&v=3

- https://www.kas.de/de/analysen-und-argumente/detail/-/content/algorithmische-entscheidungen-transparenz-und-kontrolle

- https://www.bertelsmann-stiftung.de/fileadmin/files/BSt/Publikationen/GrauePublikationen/Algo.Rules_DE.pdf

- https://ec.europa.eu/germany/news/20210421-kuenstliche-intelligenz-eu_de

- https://www.tab-beim-bundestag.de/de/pdf/publikationen/berichte/TAB-Hintergrundpapier-hp024.pdf

![[Un]nahbar [Un]nahbar](https://wp.zim.uni-passau.de/unnahbar/wp-content/uploads/sites/8/2021/07/Schriftzug_JMC-2021.png)